日本マイクロソフト株式会社 技術統括室 エンジニア

千葉慎二さん

MicrosoftというとパソコンOSのWindowsやワープロソフトWordや表計算ソフトExcelなどのオフィス製品でおなじみの会社だ。しかしMicrosoftは、障がいのあるなしや年齢など関係なく、テクノロジーの恩恵を受けられる社会の実現を企業理念としている。実際にWindowsにも、30年前のWindows 95の時代から始まり最新のWindows 11まで、次々と多くの技術が投入されてきた。また、視覚障がい者の移動を支援も可能にする「Seeing AI」というアプリをリリースしており、多くの人に使われている。

そこで、Microsoftが取り組む特に視覚障がい者のための支援技術を中心に、日本マイクロソフト株式会社の千葉慎二さんにお話を伺った。

Windowsの中には障がい者支援機能が入っている

――Microsoftというと真っ先にパソコンOSが思い浮かぶのですが、千葉さんはどんな仕事をなさっているのですか?

Microsoftの中で新しい技術、主に複合現実(MR: Mixed Reality)という最先端技術の活用を推進する仕事に携わっています。もうひとつが、障がいを持った方や高齢者の方をテクノロジーの力で支援するという仕事です。

――普段私たちが使っているWindowsの中にも障がい者を支援する機能があるのですか?

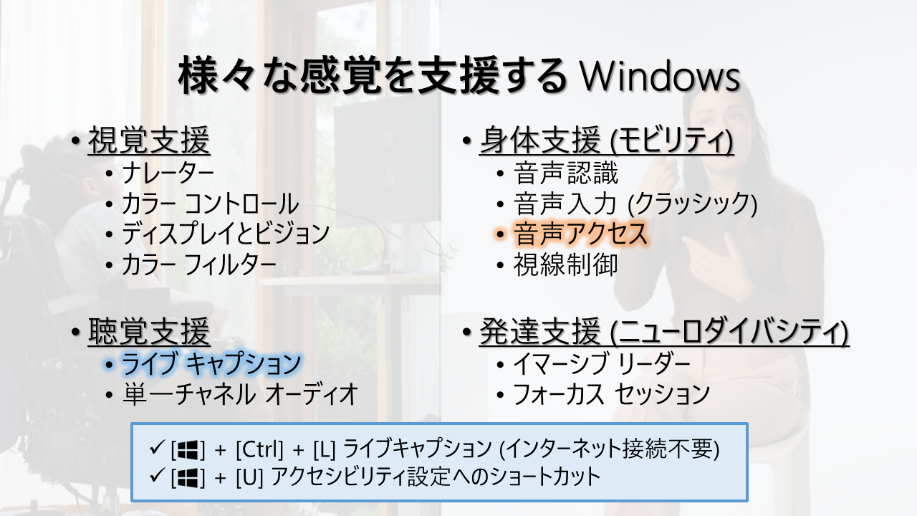

はい。私たちは「様々な感覚を支援する」と言っているのですが、「視覚」「聴覚」「身体」「発達」といった障がいを支援する技術がWindowsには入っています。(図1)。

たとえば音声アクセス機能を使うと、Windowsを声で操作することができますし、ライブキャプション機能を使うと、Windows上で再生されるどんな音声でもそれを文字に起こして表示してくれます。

スマートフォンのカメラが映したものを読み上げる「Seeing AI」

――一般にも人工知能(AI)技術がよく知られるようになってきましたが、Microsoftの製品にもAI技術が使われているのですか?

はい、正にそうです。Microsoftにはコグニティブ(Cognitive:認知)サービスと呼ぶクラウドのAIサービスがあるのですが、そういった技術がWindowsやOffice製品でも用いられています。

そして、そのサービスを利用したスマートフォンで動く視覚障がい者向け読み上げアプリとして2017年にリリースされたのが「Seeing AI」です(図2)。実際の利用シーンを紹介する動画も公開されています。

――「Seeing AI」はスマートフォンのカメラに映るシーンを何でも音声で説明するアプリなのですね。

単にカメラで映した文字を読み上げるだけではありません。人の顔を登録しておくとその人の名前や、顔の表情や何をしているかを声で教えてくれます。洋服の色を知らせたり、部屋の明るさを音の高低で表現したりもしてくれます。

公開されているSeeing AIの動画は2019年時点のものであり、発音の仕方に不自然なところがありますが、コグニティブサービスのスピーチ機能はここ数年で飛躍的に進化してとても自然な読み上げができるようになってきています。

このアプリは現在18言語・83地域に対応しており、それらは今後も増える予定です。またこれまでiPhone版しかなかったのですが、2023年12月にAndroid版もリリースされました。いずれも無料でご使用いただけます。

――最近NHKではAIアナウンサーがニュース原稿を読み上げることがあります。かなり自然に聞こえるのですが、具体的に読み上げにはどのような工夫がありますか?

日本語には同音異義語が多いので、文脈に応じた適切なイントネーションの発話が必要になります。またMicrosoftでは、息継ぎの呼吸も含めたノイズのようなものをのせて、より自然に聞こえるようにする工夫もしています。

ただ、人間と区別できないほどに自然な発話ができるようになると、その技術が偽動画に悪用されかねません。そこは、今盛んに議論されているAI倫理の規制なりに従っていくことなるでしょう。

生成AIの可能性

――Microsoftは特に生成AIについて熱心に取り組んでいますね。

先ほどお話ししたコグニティブサービスは外から入ってくる様々な情報を“認知”するAIですが、生成AIは普段人が話す言葉で指示(プロンプト)を与えることによって、その答えを“生成”してくれる特徴があります。人間は同じようなことを何度も問いかけたり尋ねたりすると相手からうんざりされがちですが、生成AIは機械なので何度でも嫌がらず誠実に答えてくれますし、人が見ても違和感の少ない文章などを返してくれます。

――生成AIの技術もMicrosoft製品に生かされるのですか?

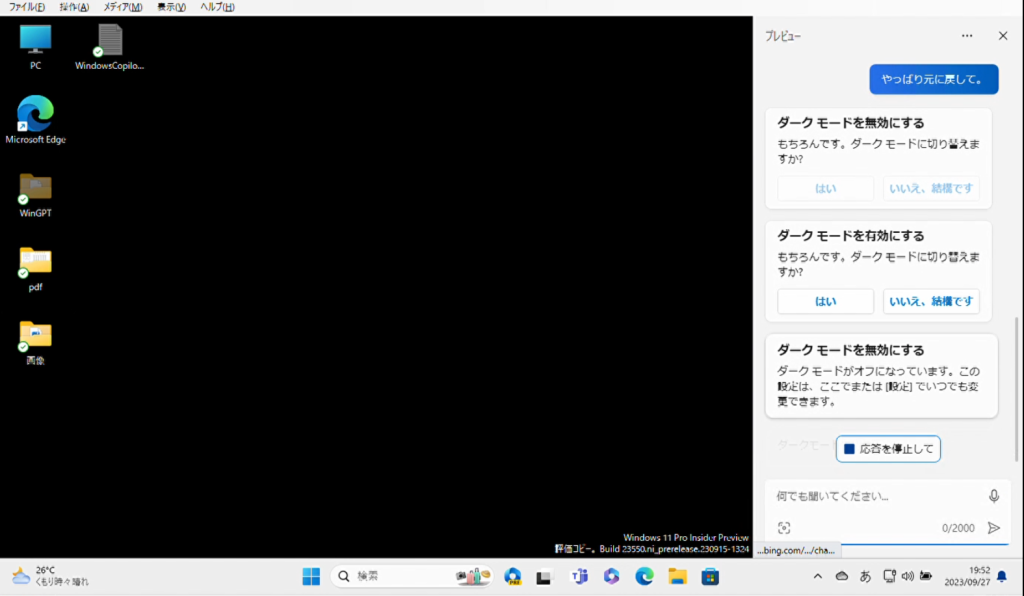

「Copilot(コパイロット:副操縦士)」という名前で今後様々な製品に組み込まれていきます。メインパイロット(主操縦士)はユーザー自身で、AIはあくまでもそれを補佐する立場という意味が込められています。

人間と生成AIの間の会話では、ユーザーの意図を理解して応えてくれるという点にも特徴があります。たとえばWindowsには、デスクトップの配色が明るすぎて見えづらい方のために画面の色合いを黒ベースにするダークモードがあります。今までは設定ウィンドウから順にたどって切り替える操作をする必要がありました。コパイロット機能を使うと「画面がまぶしいです」とAIにチャットで伝えるだけで簡単にダークモードへ切り替えられます。そして「やっぱり元に戻して」と言うとそれまでのユーザーとの会話の文脈を理解して、元のライトモードに戻すことができます。これは、操作が不自由な人には大きな助けになります。

――ほかに生成AIの有効な応用例を紹介いただけますか?

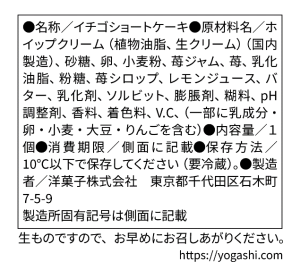

先ほどの「Seeing AI」などの読み上げ機能は、一般的にカメラに映った左上の文字から順番に読んでいきます。たとえばケーキの箱に商品の説明があったとします(図4)。「イチゴショートケーキ」と書いてありますが、保存方法が知りたいと思った場合、左上から順番に早口で読んでいっても、たどりつくまでに時間がかかります。そこで生成AIに項目別に分類してもらうことで、必要な情報に素早くアクセスできるようになるでしょう。

――これからの支援技術は、生成AIにどう向き合っていくべきとお考えですか?

当社に限らずどのソフトウェア会社も、誰にでも使えるコンピュータの実現のためにわかりやすい簡単な操作を実現してきました。その成果も出ていて、身体に不自由があってもそれを支援するソフトウェアやハードウェアが使えるようになってきています。しかしまだまだ人間がコンピュータに合わせなければならないことが多く、これだとやはりどうしても使いこなせずに取り残されてしまう人が出てくる。

生成AIはこの関係を逆転させられる可能性を持っています。人間は、コンピュータにしてもらいたいことを自分の言葉で伝えるだけで良くなるからです。

生成AIの技術はまだスタートしたばかりです。この技術をうまく製品の中に取り込んで、よりアクセシブルな機能や新たな支援サービスが数多く誕生することを切に願っています。

国土交通省プロジェクトへの期待

――国土交通省の「歩行空間ナビ・プロジェクト」では、歩行空間における段差などのバリア情報やバリアフリー施設の情報を「歩行空間ネットワークデータ」としてオープンデータ化し、移動支援サービスの普及・高度化を促進する事業を進めています。今後、こうした事業とどのような連携が考えられますでしょうか?

「Seeing AI」は、主にカメラから得られる情報を用いて、視覚障がい者のための様々な機能を持たせています。そのためカメラに映る範囲で起こる変化を即座に捉えることができます。しかしその範囲を越えるような場合、たとえば利用者が移動を伴うようなケースにおいては周辺の歩行空間ネットワーク、近隣施設の情報といったオープンデータと連携させることによって、より高いレベルで視覚障がい者の移動を支援できる可能性があると考えられます。

――国土交通省は、様々な分野でのオープンデータ化を進めています。御社として期待していることはありますか?

過去に当社は、バス運行情報のオープンデータを使った「わたしのバス」のサービスの開発を支援させていただきました。今後、公共交通機関、歩行空間などの情報がオープンデータ化されていくことによって、既存のサービスをより良くしたり新しい価値あるサービスを生み出したりすることが可能になります。こうした情報インフラの整備は、民間だけではどうしても行き届かないところが出てきますので、官民がうまく連携して進めていくことが重要であると考えています。それらを実現する鍵となる、国土交通省さまのプラットフォームやデータ整備仕様等の環境整備のお取り組みにはとても期待をしています。