筑波技術大学 保健科学部 情報システム学科 助教

松尾 政輝さん(写真左)

全国高等学校長協会入試点訳事業部 理事

高村 明良さん(写真右)

筑波技術大学は、茨城県つくば市にある日本で最初に視覚障がい者と聴覚障がい者であることを入学条件にした国立大学法人である。長らく視覚や聴覚の障がいがある高校生は大学入試すら受けることができないという状況が続いていた。しかし、筑波大学附属盲学校(現、筑波大学附属聴覚特別支援学校)から新校設立に向けた運動が始まり、それが契機となり1987年に前身である筑波技術短期大学が誕生、今に至っている。

今回は、筑波技術大学で教壇に立ち、自身も先天性の全盲の松尾政輝さん、そして筑波大学附属盲学校で永年教鞭を取ってきた全盲の高村明良さんに一緒にお話を伺った。高村さんの教え子の一人が松尾さんという関係でもある。

スマートフォンは視覚障がい者の大きな助け

――松尾さんは筑波技術大学ではどういった教育や研究の活動をされているのですか?

松尾: 情報システム学科で障がいを持つ学生を対象にプログラミングを教えています。研究としては、障がいの有無によらず楽しめるゲーム開発や、視覚障がい者のための歩行移動支援機器などを障がい当事者と一緒に開発しています。

――このところの視覚障がい者のための支援技術の動向をどのように見ていらっしゃいますか?

松尾:以前は、福祉機器という専用機を使うことが主流でした。しかしここ10年ぐらいスマートフォンが当たり前になりその中の障がい者対応機能(アクセシビリティ機能)が充実してくると、そうした一般に普及する機器をうまく使って支援をしていく動きが活発になってきました。専用機にこれだけのハードウェアやソフトウェアを装備するとたいへん高価になってしまいます。その点、広く普及する機器だからこそ気楽に使えて、そこに多くの支援機能が搭載されるというのは、良い方向だと思います。

スマートフォンを使った視覚障がい支援には大きく二つあります。一つはカメラに映った情報を音声で伝える機能です。文書であればそこに書いてある活字を読み上げますし、文字でない場合でも映っているものを説明してくれます。

もう一つは、視覚障がい者には難しい単独歩行を支援する機能です。スマートフォンにはGPS、位置情報コンパス情報、方向センサー、カメラ、距離センサーが備わっています。ユーザーの位置情報や周辺の空間情報、経路情報も使い、視覚以外の音声や振動を使って視覚障がい者の歩行を支援する研究が行われています。

生成AIを使った「Be My AI」の可能性

――iPhone用の「Be My Eyes」というアプリが知られているようです。

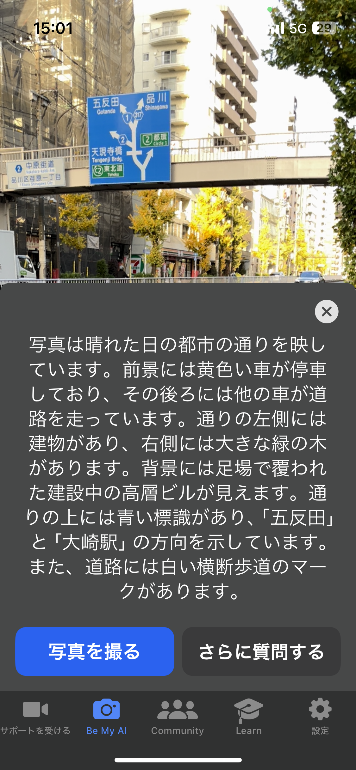

松尾:「Be My Eyes」は、スマートフォンが映した映像をボランティアにつなぎ、通話により支援を受けるというアプリです(図1)。デンマーク生まれのアプリですが、日本語が問題なく使えます。全世界で50万人の視覚障がい者が使っていて、登録しているボランティアも600万人に達します。

支援を受けたいと思った視覚障がい者がアプリから支援を要請すると、ボランティアたちのスマートフォンに支援要請の通知が届きます。最初に取ったボランティアと障がい者がつながります。ボランティアは、音声通話を通じてカメラに映った映像から文字の読み上げ、モノ探し、機器の操作支援、歩行支援などを行います。

私もときどき使うのですが、はじめて買った電化製品の操作パネルを見てもらうとか、外出先で目的地がわからなくなったとき、立ち止まって周囲をカメラで写し、目印になるような看板を見つけてもらうといった使い方ができます。

技術の使い方として、アプリそのもので障がい者を支援するのではなく、アプリで障がい者とボランティアをネットでつなぐという発想が素晴らしいと思います。

――最近、生成AIを使った「Be My AI」という機能が加わったと聞きました。

松尾:「Be My AI」は、人間のボランティアの代わりに、OpenAIのGPT-4のエンジンが視覚の代行をしてバーチャルボランティアの役割を果たします(図2)。ユーザーが撮影した写真をAIが解析して、風景なら空間に何が写っているのか、その場所や物について日本語で読み上げてくれます。説明を受けるだけではなくて、追加質問もできます。これは生成AIのメリットです。まだ複雑なレイアウトを誤認識するケースがありますが、大きな可能性を感じています。

高村:「Be My Eyes」のほうは、リアルにボランティアとつながるので、簡単な内容とはいえ頼みにくいと思ってしまいます。その点「Be My AI」は、気兼ねなく使うことができるのが大きなメリットです。

歩行支援をする「Eye Navi」

――スマートフォンを使ったもう一つの支援である歩行支援はどうですか?

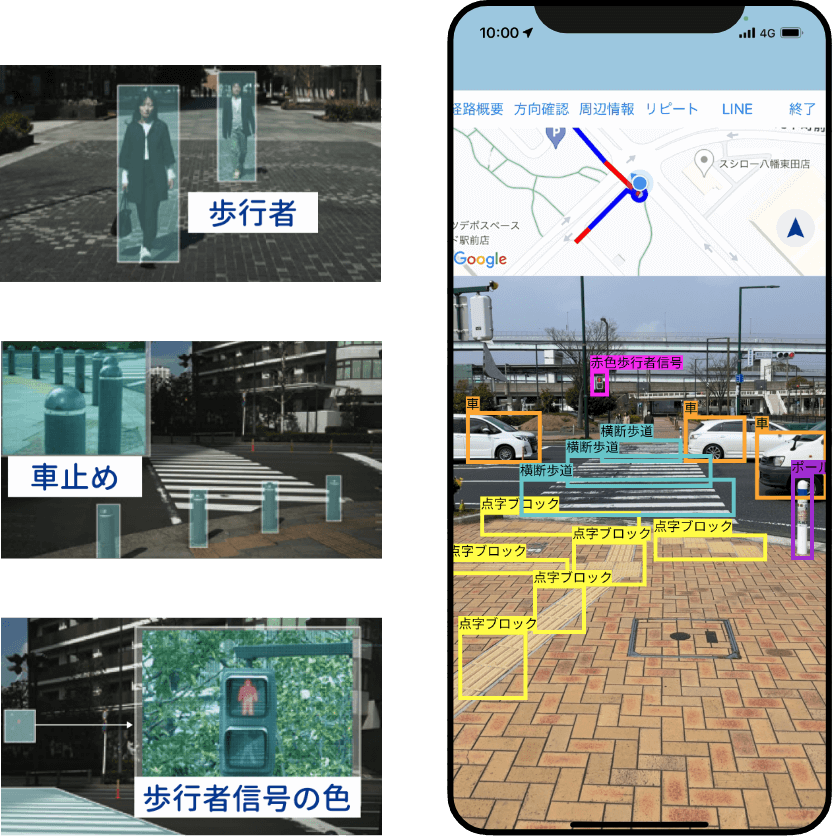

松尾: iPhone用の「Eye Navi」という日本製のアプリがあります(図3)。歩くときに、カメラを外に向けたiPhoneを首からさげ、イヤフォンで音声を聞いて支援を受けます。道案内では、目印となる店の名前、正しい方向へ向かっているか、目標までの距離などを音声案内でリアルタイムに教えてくれます。また特に障がい者の助けとなるよう、障害物・自動車・横断歩道・点字ブロックの検出や歩行者信号の色も知らせてくれます。

まだ生まれたばかりのアプリですので改善点はいろいろ残されているようです。たとえば、前の人について歩いているのに、ずっとその人を障害物だと認識して発声し続けてしまいます。しかしこのアプリにも、大きな可能性を感じています。

高村:ほかにも、歩行者用信号機の色を、ずっと「赤です」とか「青です」とかと言い続けてしまい、もっと重要な音声に気づかなくなる可能性がありそうです。信号の色の検出漏れでユーザーを危険な目に遭わせたくないという意図はわかります。しかし、周りの状況を適切に判断して、必要な情報を厳選して伝えるという方向性が必要だと思います。

歩行支援はスマートフォン利用が主流に?

――これからの視覚障がい者のための歩行支援は、スマートフォンを使ったものが主流になるのでしょうか? それともやはり白杖も使い続けられるのか。

高村:スマートフォン以外にも、白杖や靴にセンサーやバイブレータを埋め込んで支援することも考えられます。しかし同時にたくさんの情報を受け取ることになり、なんとなくの気配で危険を感じることがおろそかになってしまいます。これからの若い人は、そういう能力が身につけられるのかもしれませんが、機器が人間側に寄り添って必要な情報の取捨選択を行うことが重要になります。そこはAIの出番のはずです。

松尾:音や触覚などを使った提示は、目がみえない人には不自由な知覚を補うものですが、目がみえる晴眼者には自分の知覚能力を増幅・拡張するものとして機能します。障がい者のための機能ではなく、ユニバーサルなデザインということになります。

高村:私もスマートフォンを使って、電車の中の空いている席を探したり、列を作って待っているときに前の人との距離を測ったりすることがあります。しかし、カメラを向けられることを不快に思う人は多くいます。

松尾:カメラに関していえば、「エンビジョングラス(Envision Glasses)」という、ウェラブルデバイスがあります(図4)。装着していても目立たず、カメラに映ったものを読み上げたり、人物、色、製品などを認識したりする機能を持っています。

高村:街中でイヤフォンしているだけで奇異な目で見られた時代があったかもしれませんが、今では普通になって、視覚障がい者は抵抗なくイヤフォンを通して音声支援を受けることができます。単に技術開発が進んでカメラに映ったものを説明できるだけでは不十分で、その技術が社会に受け入れられるために何が必要なのかを同時に考えていく必要があるのでしょう。

「歩行空間ナビ・プロジェクト」への期待

―― 国土交通省の「歩行空間ナビ・プロジェクト」では、歩行空間における段差などのバリア情報やバリアフリー施設の情報を、「歩行空間ネットワークデータ」や「施設データ」としてオープンデータ化し、移動支援サービスの普及・高度化を促進する事業を進めています。視覚障がい者の当事者として、こうした事業に期待していることはありますか?

高村:Eye Naviのようにカメラからの映像をリアルタイムに解析して障害物を認識する充実した歩行支援アプリが増えてくると思います。一方、「歩行空間ネットワークデータ」からは、段差、音響設備のある信号機、誘導ブロックの有無などの情報も得られるとのことです。特に、カメラでは認識が難しい情報もたくさん得られるようです。そこで、歩行支援アプリがカメラとネットワークデータからの両方の情報を組み合わせれば、より適切に視覚障がい者に必要な情報を音声で受けられるようになると思います。このプロジェクトの成果にたいへん期待しています。